مقایسه کارت گرافیکهای RADEON PRO با QUADRO

کارت گرافیک یکی از مهمترین اجزای هر سیستم کامپیوتری است. این قطعه وظیفه دارد تصاویر، ویدیوها و مدلهای سهبعدی را پردازش و نمایش دهد.

در بیشتر رایانهها از کارتهای گرافیک معمولی برای اجرای بازیها و برنامههای روزمره استفاده میشود، اما در دنیای حرفهای و سیستم های رندرینگ، مثل طراحی صنعتی، انیمیشنسازی، مهندسی و تولید محتوا، به سختافزارهایی نیاز است که پایداری و دقت بسیار بالایی داشته باشند.

در این حوزه دو شرکت بزرگ نقش اصلی را ایفا میکنند: AMD با سری Radeon Pro و NVIDIA با سری Quadro. هر دو سری برای کاربران حرفهای طراحی شدهاند و تمرکز آنها روی کارایی بالا در نرمافزارهای تخصصی است، نه اجرای بازیها.

معرفی سری Radeon Pro

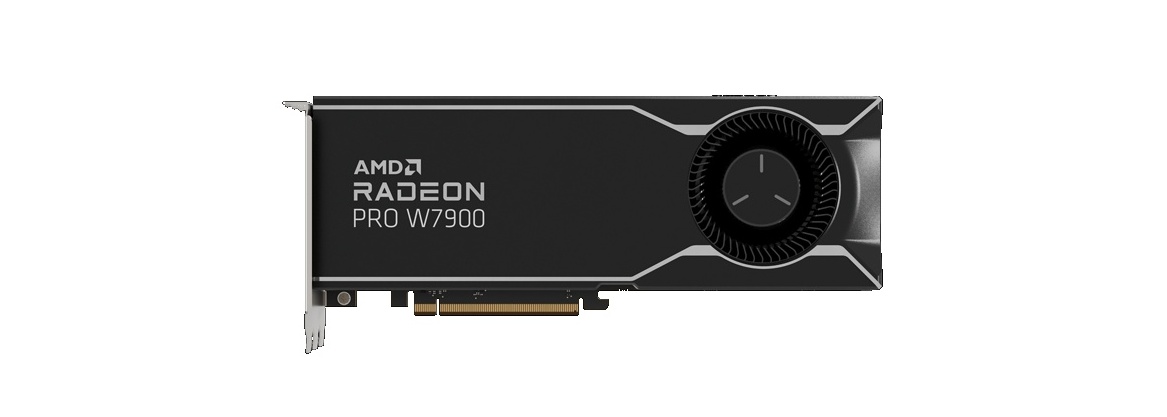

سری Radeon Pro محصول شرکت AMD است و برای کاربرانی طراحی شده که به دقت، پایداری و راندمان بالا در کارهای حرفهای نیاز دارند.

این کارتها در واقع نسخههای بهینهشده و صنعتیتر کارتهای گیمینگ Radeon هستند، اما تفاوت اصلی در نحوه عملکرد و درایورهای مخصوص آنهاست.

AMD در طراحی Radeon Pro تمرکز خود را بر روی کارایی پایدار در طول زمان و سازگاری کامل با نرمافزارهای مهندسی و طراحی قرار داده است. درایورهای مخصوص این سری به طور ویژه برای نرمافزارهایی مثل Autodesk AutoCAD، SolidWorks، Revit، Adobe Premiere Pro و Blender بهینهسازی شدهاند. این یعنی کاربر میتواند بدون نگرانی از خطاهای گرافیکی یا هنگ کردن نرمافزار، پروژههای سنگین را با ثبات بالا اجرا کند.

از نظر فنی، کارتهای Radeon Pro معمولاً دارای حافظه ECC (Error Correction Code) هستند که خطاهای حافظه را به صورت خودکار اصلاح میکند. این ویژگی برای کارهای حساس مانند طراحی مدار، شبیهسازیهای علمی یا رندرینگ سهبعدی اهمیت زیادی دارد.

همچنین AMD در این سری از معماری RDNA و RDNA2 استفاده کرده که باعث افزایش راندمان انرژی و قدرت پردازشی میشود. مدلهایی مانند Radeon Pro W6600، W6800 و W7900 از نمونههای محبوب این سری هستند و در ایستگاههای کاری حرفهای مورد استفاده قرار میگیرند.

معرفی سری Quadro

سری Quadro محصول شرکت NVIDIA است و یکی از شناختهشدهترین نامها در دنیای کارتهای گرافیک حرفهای به شمار میرود.

این سری برای طراحان، مهندسان، انیماتورها و پژوهشگرانی ساخته شده که نیاز به دقت بالا، ثبات در عملکرد و پشتیبانی نرمافزاری گسترده دارند.

در مقایسه با کارتهای گیمینگ NVIDIA مثل سری GeForce، کارتهای Quadro تمرکز بیشتری بر روی دقت محاسبات، رندرینگ علمی و سازگاری با نرمافزارهای صنعتی دارند. درایورهای حرفهای Quadro به طور ویژه برای نرمافزارهای سهبعدی و مهندسی مانند 3ds Max، Maya، SolidWorks، CATIA و Siemens NX بهینهسازی شدهاند. این بهینهسازی باعث میشود عملکرد در این برنامهها بسیار روان و بدون ناپایداری باشد.

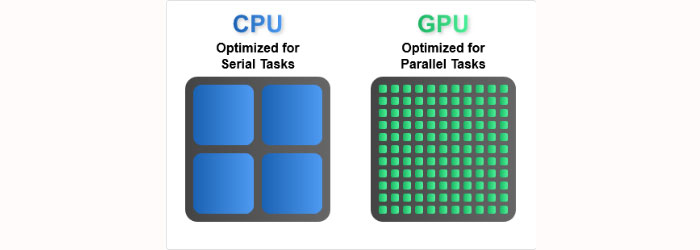

یکی از ویژگیهای کلیدی سری Quadro استفاده از فناوریهای خاص NVIDIA مثل CUDA و OptiX است. فناوری CUDA به برنامهها اجازه میدهد از قدرت پردازشی کارت گرافیک برای انجام محاسبات پیچیده استفاده کنند، در حالی که OptiX برای شتابدهی به فرآیند رندرینگ با نور واقعی (Ray Tracing) کاربرد دارد. این قابلیتها باعث میشوند Quadro انتخابی عالی برای کارهای رندرینگ، شبیهسازی فیزیکی و حتی یادگیری ماشین باشد.

از نظر سختافزاری، کارتهای Quadro معمولاً دارای حافظه زیاد (تا ۴۸ گیگابایت در مدلهای بالا)، پهنای باند بالا و پشتیبانی از دقت رنگ ۱۰ و ۱۲ بیت هستند. مدلهای معروف این سری شامل Quadro P2200، RTX 4000، RTX 5000، RTX 6000 و RTX 8000 هستند که هر کدام متناسب با سطح کاری متفاوتی طراحی شدهاند.

مقایسه فنی و عملکردی

وقتی صحبت از مقایسه فنی بین سری Radeon Pro و Quadro میشود، هر دو برند ویژگیهای قدرتمندی ارائه میدهند، اما رویکرد و اولویتهای آنها متفاوت است.

از نظر توان پردازشی، هر دو برند از معماریهای مدرن خود استفاده میکنند. AMD با معماری RDNA و RDNA2 توانسته قدرت پردازشی بالا را در کنار مصرف انرژی کمتر فراهم کند. در مقابل، NVIDIA در کارتهای Quadro از معماری Turing و در مدلهای جدیدتر از Ampere بهره میبرد که تمرکز زیادی بر پردازش موازی و هوش مصنوعی دارد. در نتیجه، کارتهای Quadro معمولاً در کارهایی مثل رندرینگ با Ray Tracing یا شبیهسازیهای فیزیکی عملکرد بهتری نشان میدهند.

از نظر حافظه گرافیکی، سری Quadro معمولاً برتری دارد. مدلهای بالارده آن حافظههایی با ظرفیت بسیار بالا و پهنای باند زیاد دارند که برای پروژههای بزرگ سهبعدی و رندرهای سنگین ضروری است. در حالی که کارتهای Radeon Pro هم از حافظه سریع GDDR6 و حتی در برخی مدلها از ECC استفاده میکنند، اما ظرفیت حافظه در بیشتر مدلها کمتر از Quadro است.

در زمینه درایورها و پایداری نرمافزاری، هر دو برند عملکرد خوبی دارند. درایورهای Radeon Pro و Quadro هر دو به صورت جداگانه برای نرمافزارهای تخصصی گواهی شدهاند (Certified Drivers). با این حال، NVIDIA سابقه طولانیتری در همکاری با شرکتهای نرمافزاری دارد، بنابراین در بسیاری از برنامهها مثل Maya یا SolidWorks، کارتهای Quadro پشتیبانی رسمیتر و بهینهتری دریافت میکنند.

از نظر دقت رنگ و رندرینگ، Quadro معمولاً برای کارهای حساس در زمینه گرافیک، چاپ و سینما انتخاب بهتری است، چون از عمق رنگ ۱۰ تا ۱۲ بیت و دقت بالا در محاسبه رنگها پشتیبانی میکند. Radeon Pro نیز در زمینه دقت رنگ عملکرد بسیار خوبی دارد، اما تمرکز اصلی آن بیشتر روی کارایی اقتصادی و تعادل بین قیمت و قدرت پردازش است.

در مورد مصرف انرژی و خنکسازی، کارتهای Radeon Pro معمولاً کمی بهینهتر هستند و حرارت کمتری تولید میکنند. این موضوع بهویژه در ایستگاههای کاری کوچکتر اهمیت دارد. در مقابل، Quadroها معمولاً مصرف انرژی بیشتری دارند اما سیستم خنککنندگی بسیار قویتری نیز در آنها تعبیه شده است.

مقایسه در کاربردهای مختلف

در انتخاب بین Radeon Pro و Quadro، نوع کاربری مهمترین عامل است. هر دو سری برای کارهای حرفهای طراحی شدهاند، اما عملکرد آنها در نرمافزارها و حوزههای مختلف تفاوتهایی دارد.

در زمینه طراحی سهبعدی و مهندسی، مانند کار با نرمافزارهای SolidWorks، AutoCAD، CATIA و Revit، کارتهای Quadro معمولاً عملکرد بهتری دارند. دلیل آن هم درایورهای بسیار دقیق و بهینهشده برای این برنامههاست. بسیاری از شرکتهای سازنده نرمافزارهای مهندسی، کارتهای Quadro را به عنوان سختافزار رسمی مورد تأیید معرفی میکنند. با این حال، Radeon Pro هم در نسخههای جدید خود پیشرفت زیادی کرده و در برنامههایی مثل AutoCAD و Fusion 360 عملکردی بسیار نزدیک به Quadro دارد.

در بخش تولید ویدیو و انیمیشن، مثل استفاده از نرمافزارهای Adobe Premiere Pro، After Effects، Blender و DaVinci Resolve، هر دو برند عملکرد خوبی ارائه میدهند. با این حال، در رندرینگ مبتنی بر GPU، کارتهای Quadro به لطف هستههای CUDA و فناوری OptiX در پروژههای سنگینتر سرعت بالاتری دارند. در مقابل، Radeon Pro معمولاً در مصرف انرژی و قیمت مقرونبهصرفهتر است، که برای تدوینگران مستقل یا استودیوهای کوچک گزینهای اقتصادیتر محسوب میشود.

در محاسبات علمی و یادگیری ماشین، Quadro به دلیل پشتیبانی کامل از CUDA و ابزارهای هوش مصنوعی NVIDIA برتری محسوسی دارد. بسیاری از کتابخانهها و فریمورکهای یادگیری عمیق مثل TensorFlow و PyTorch بر اساس CUDA توسعه یافتهاند، بنابراین کاربرانی که در زمینه تحقیقاتی یا پردازش داده فعالیت میکنند، معمولاً Quadro را انتخاب میکنند.

در زمینه سازگاری با سیستمعاملها، هر دو برند از ویندوز و لینوکس پشتیبانی میکنند. با این حال، Quadro معمولاً پشتیبانی نرمافزاری دقیقتری در سیستمهای لینوکسی دارد، در حالی که Radeon Pro در سیستمهای ویندوزی و مکبوکهای مخصوص تولید محتوا عملکرد روانتری دارد.

قیمت و ارزش خرید

در بازار سختافزار، قیمت کارتهای گرافیک حرفهای معمولاً تابع عوامل متعددی است: مدل (رده پایین، متوسط، بالا)، ظرفیت حافظه، ویژگیهای خاص (مثل ECC، پهنای باند زیاد، قابلیتهای رندرینگ سختافزاری) و وضعیت عرضه و تقاضا. همچنین تفاوت قیمتی بین برندها به دلیل شهرت، پشتیبانی نرمافزاری و بازار هدف نیز زیاد است.

برای مثال، کارت Radeon Pro W7700 توسط AMD عرضه شده با قیمت تقریباً ۹۹۹ دلار .

در بازار کارتهای Radeon Pro، مدلهای پایینتر مثل WX 3200 در حدود ۱۴۹٫۹۹ دلار دیده شده است ، و مدلهایی مانند W6600 در رده میانی نیز قیمتی نزدیک به ۳۹۹٫۹۹ دلار دارند .

از طرف دیگر، کارت Quadro P620 با حافظه ۲ گیگابایت به قیمت حدود ۳۱۴٫۹۹ دلار عرضه میشود .

مقایسه ارزش در برابر قیمت

وقتی قیمتها رو دیدیم، نکات زیر در تحلیل «ارزش خرید» اهمیت دارند:

در رده پایین یا متوسط، Radeon Pro معمولاً قیمت بهتری نسبت به عملکرد نسبت به Quadro ارائه میدهد. یعنی برای هزینهای کمتر، به کاربر حرفهای امکانات قابل قبولی دارد.

اما در ردههای بالا، فاصله قیمت ممکنه زیاد بشه، ولی تفاوت عملکرد، پایداری و پشتیبانی نرمافزاری Quadro خودش رو نشان میده. برای پروژههای سنگین، کارت Quadro ممکنه گزینهای مطمئنتر باشه حتی اگر هزینه بیشتری داشته باشه.

همچنین باید هزینه جانبی مثل خنکسازی، مصرف انرژی و تعمیرات رو هم حساب کرد. اگر یک کارت Quadro عمر بیشتری داشته باشه یا در پروژههای سنگین کمتر مستهلک بشه، هزینه کل مالکیت پایینتر خواهد بود.

قیمت و ارزش خرید در بازار ایران

در بازار سختافزار ایران، قیمت کارتهای گرافیک حرفهای به عوامل زیادی وابسته است؛ از نوسانات نرخ ارز گرفته تا میزان واردات و موجودی فروشندگان. به همین دلیل، اختلاف قیمت بین مدلهای Radeon Pro و Quadro ممکن است از بازار جهانی بیشتر باشد.

به طور کلی، کارتهای Radeon Pro در ایران معمولاً مقرونبهصرفهتر از مدلهای مشابه Quadro هستند. برای مثال، کارت Radeon Pro W6600 که در بازار جهانی حدود ۴۰۰ دلار قیمت دارد، در ایران بسته به برند و گارانتی بین ۴۰ تا ۵۵ میلیون تومان به فروش میرسد. در حالی که کارت Quadro RTX 4000 که از نظر عملکرد در همان رده قرار میگیرد، معمولاً با قیمتی بین ۸۰ تا ۱۱۰ میلیون تومان عرضه میشود.

در مدلهای پایینتر، مانند Radeon Pro WX 3200، قیمت در محدوده ۲۰ تا ۲۵ میلیون تومان است، در حالی که کارت Quadro P620 یا T600 معمولاً بین ۲۵ تا ۳۵ میلیون تومان قیمت دارند.

این اختلاف قیمت نشان میدهد که برای کاربرانی که پروژههای سبک تا متوسط انجام میدهند، خرید Radeon Pro میتواند انتخاب اقتصادیتر و منطقیتری باشد. از سوی دیگر، در شرکتهای بزرگ یا محیطهایی که پایداری نرمافزاری و پشتیبانی رسمی اهمیت بالایی دارد، سرمایهگذاری روی Quadro همچنان توجیهپذیر است.

نکته دیگر این است که در بازار ایران، قطعات Quadro کمتر در دسترس هستند و تنوع مدلهای Radeon Pro معمولاً بیشتر است. همچنین تعمیر یا تعویض کارتهای AMD سادهتر و هزینهاش پایینتر است، چون قطعات جایگزین بیشتری در بازار وجود دارد.

سخن پایانی

هر دو سری Radeon Pro از AMD و Quadro از NVIDIA برای کاربران حرفهای طراحی شدهاند، اما مسیر و فلسفهی طراحی آنها کمی متفاوت است.

Radeon Pro تلاش میکند با قیمت مناسبتر، عملکرد بالا و درایورهای پایدار، نیاز کاربران حرفهای مستقل، طراحان و تولیدکنندگان محتوا را برطرف کند. در مقابل، Quadro با تمرکز بر پایداری مطلق، پشتیبانی رسمی نرمافزاری و دقت بینقص در رنگ و رندرینگ، انتخاب محبوب شرکتها، استودیوها و محیطهای صنعتی بزرگ است.

از نظر قدرت سختافزاری، Quadro معمولاً در پروژههای سنگینتر مثل رندرینگ واقعگرایانه، شبیهسازیهای علمی یا یادگیری ماشین بهتر عمل میکند. در حالی که Radeon Pro با مصرف انرژی پایینتر و قیمت اقتصادیتر، برای کارهای طراحی، مدلسازی سهبعدی و تدوین ویدیو گزینهای بسیار منطقی است.

در بازار ایران، تفاوت قیمت بین این دو سری بیشتر به چشم میآید و همین موضوع باعث میشود بسیاری از کاربران حرفهای به سمت Radeon Pro بروند. با این حال، کسانی که پایداری نرمافزاری در سطح سازمانی یا پشتیبانی بلندمدت نیاز دارند، هنوز Quadro را ترجیح میدهند.

وقتی صحبت از ساخت یک

وقتی صحبت از ساخت یک