پنج نرمافزار ادیت فیلم به کمک هوش مصنوعی

در دنیای امروز که ویدیوها بخش مهمی از زندگی دیجیتال ما را تشکیل میدهند، ویرایش فیلم دیگر فقط کار حرفهایها نیست. از تولیدکنندگان محتوا در یوتیوب و اینستاگرام گرفته تا معلمان و صاحبان کسبوکارهای کوچک، همه به نوعی با ادیت ویدیو سر و کار دارند. اما گاهی ویرایش فیلم زمانبر و پیچیده به نظر میرسد.

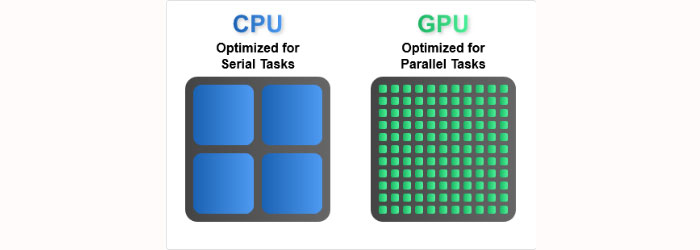

اینجاست که هوش مصنوعی وارد عمل میشود. هوش مصنوعی یا همان AI ، به زبان ساده یعنی توانایی کامپیوتر برای انجام کارهایی که قبلاً فقط انسان میتوانست انجام دهد، مثل تشخیص چهره، درک صدا یا تصمیمگیری. این فناوری حالا به کمک ویرایش ویدیو آمده تا کار را سریعتر، سادهتر و حرفهایتر کند.

در این مقاله، قرار است با پنج نرمافزار ادیت فیلم به کمک هوش مصنوعی آشنا شویم که از هوش مصنوعی برای ویرایش فیلم استفاده میکنند. این ابزارها میتوانند به شما کمک کنند تا ویدیوهای بهتری بسازید، حتی اگر تجربه زیادی در تدوین نداشته باشید.

چرا هوش مصنوعی در ویرایش فیلم مهم شده است؟

در گذشته، برای ویرایش یک فیلم کوتاه ممکن بود ساعتها یا حتی روزها زمان صرف شود. کارهایی مثل برش صحنهها، تنظیم نور و رنگ، حذف نویز صدا یا ساخت زیرنویس، همگی به مهارت و دقت بالا نیاز داشتند. اما امروزه با پیشرفت هوش مصنوعی، بسیاری از این کارها را میتوان با چند کلیک ساده انجام داد.

هوش مصنوعی بهطور خودکار و با دقت بالا میتواند تشخیص دهد که کدام صحنه مهمتر است، یا حتی کجا باید افکت خاصی اعمال شود. مثلاً اگر در یک ویدیو چند نفر صحبت میکنند، سیستم هوشمند میتواند بهراحتی صدای هر فرد را جدا کند، زیرنویس دقیق بنویسد و حتی حرکت لب را با متن هماهنگ کند.

یکی از مزایای اصلی استفاده از AI در ویرایش فیلم، صرفهجویی در زمان است. کاری که قبلاً چند ساعت زمان میبرد، حالا ممکن است در چند دقیقه انجام شود. همچنین دقت کار بالا میرود و احتمال خطاهای انسانی کمتر میشود.

دیگر ویژگی جذاب این فناوری، سادگی استفاده است. امروزه نرمافزارهایی وجود دارند که فقط با وارد کردن یک متن، برای شما یک ویدیوی کامل میسازند. یا ابزارهایی که پسزمینه ویدیو را بدون نیاز به پرده سبز، حذف میکنند.

با توجه به این مزایا، عجیب نیست که هوش مصنوعی به یکی از ابزارهای اصلی در ویرایش فیلم تبدیل شده و روز به روز محبوبتر میشود.

معرفی پنج نرمافزار برتر ویرایش فیلم با کمک هوش مصنوعی

در دنیای پرسرعت امروزی، نرمافزارهایی که کار ویرایش فیلم را سادهتر و سریعتر میکنند، بسیار ارزشمند هستند. در ادامه، پنج نرمافزار هوشمند را بررسی میکنیم که با استفاده از فناوری هوش مصنوعی، تدوین ویدیو را حتی برای مبتدیان هم ممکن کردهاند.

Runway ML

Runway ML یک نرمافزار قدرتمند ابری (cloud-based) است که امکانات متنوعی برای ویرایش ویدیو با استفاده از مدلهای یادگیری ماشین ارائه میدهد. این پلتفرم بیشتر برای پروژههای هنری، خلاقانه و محتوای دیجیتال استفاده میشود.

ویژگیهای برجسته:

قابلیت حذف پسزمینه و سوژهها بدون نیاز به پرده سبز.

افکتهای هوشمند مثل تار کردن پسزمینه، تعویض آسمان، تغییر سبک بصری.

امکان ایجاد ویدیوهای سورئال با مدلهای هوش مصنوعی مانند Stable Diffusion یا StyleGAN

کاربردها:

افرادی که در زمینهی طراحی گرافیکی، تولید محتوا یا تبلیغات فعالیت میکنند.

ساخت کلیپهای کوتاه با ظاهر حرفهای بدون نیاز به تجهیزات پیشرفته.

Adobe Premiere Pro (با فناوری Sensei)

Premiere Pro نرمافزاری است که اغلب فیلمسازان، تدوینگران و تولیدکنندگان محتوای حرفهای از آن استفاده میکنند. Adobe با اضافه کردن فناوری Sensei به این نرمافزار، آن را هوشمندتر و کارآمدتر کرده است.

امکانات هوش مصنوعی در Premiere Pro:

تنظیم خودکار رنگ و نور بر اساس صحنه.

Auto Reframe برای تنظیم اندازه تصویر برای شبکههای مختلف (مثلاً یوتیوب، اینستاگرام، تیکتاک).

حذف خودکار نویز صدا و انتخاب بهترین لحظات.

ساخت زیرنویس بهصورت خودکار از فایل صوتی یا ویدیویی.

برای چه کسانی مناسب است؟

کاربران حرفهای که به امکانات پیشرفته نیاز دارند.

کسانی که پروژههای طولانی و سنگین ویرایش میکنند.

تولیدکنندگان فیلم، ویدیوهای تبلیغاتی و یوتیوبرهای حرفهای.

Descript

اگر دنبال راهی ساده و سریع برای تدوین ویدیوهای گفتاری مثل پادکستها، ویدیوهای آموزشی یا مصاحبهها هستید، Descript انتخاب هوشمندانهای است.

چرا Descript خاص است؟

با تبدیل صدای ویدیو به متن، به شما این امکان را میدهد که فقط با ویرایش متن، ویدیو را هم ویرایش کنید.

حذف سکوتهای طولانی یا کلمات زائد مثل «اِممم» بهصورت خودکار.

تولید صدای مصنوعی از صدای شما با استفاده از تکنولوژی “Overdub”

مناسب چه افرادی است؟

کسانی که میخواهند سریع و ساده تدوین انجام دهند.

مدرسان آنلاین، پادکسترها، بلاگرها و سازندگان ویدیوهای آموزشی.

Pictory

Pictory به شما اجازه میدهد از طریق متن، ویدیو بسازید. کافی است اسکریپت یا مقالهی خود را وارد کنید، و این نرمافزار بر اساس آن تصاویر و کلیپهای مناسب را انتخاب کرده و یک ویدیوی کامل تولید میکند.

امکانات کلیدی:

تبدیل مقاله یا متن به ویدیو در چند دقیقه.

افزودن خودکار زیرنویس، لوگو و موسیقی.

کتابخانه بزرگی از تصاویر و ویدیوهای آماده برای استفاده.

کاربردها:

بازاریابهای محتوا و دیجیتال مارکترها.

بلاگرها و افرادی که میخواهند از نوشتههایشان ویدیو بسازند.

مناسب برای تولید محتوای یوتیوب و اینستاگرام بدون نیاز به فیلمبرداری.

Magisto

Magisto یک اپلیکیشن موبایلی است که ویرایش فیلم را بهصورت تمامخودکار انجام میدهد. این برنامه برای کسانی طراحی شده که وقت یا مهارت تدوین ندارند اما میخواهند ویدیوی جذاب و تاثیرگذار بسازند.

ویژگیهای هوشمند:

تحلیل خودکار محتوای تصویری و انتخاب بهترین صحنهها.

تنظیم موزیک، افکت و برش صحنهها به شکل خودکار.

تولید سریع ویدیو برای مناسبتهای خاص، تبلیغات، معرفی محصول و…

مناسب برای:

کاربران شبکههای اجتماعی.

صاحبان کسبوکارهای کوچک.

افرادی که میخواهند روی گوشی خود بهسرعت ویدیو بسازند.

مقایسه و جمعبندی نرمافزارها

نرمافزارهای معرفیشده در این مقاله هرکدام برای نیازهای خاصی طراحی شدهاند.

اگر کار حرفهای انجام میدهید و به امکانات پیشرفته نیاز دارید، Adobe Premiere Pro با کمک هوش مصنوعی Sensei بهترین انتخاب است. اگر بهدنبال ابزار خلاقانه برای حذف پسزمینه یا افکتهای خاص هستید، Runway ML را امتحان کنید.

برای تولیدکنندگان محتوای گفتاری، آموزشی یا پادکست، Descript یک راهحل ساده و متفاوت ارائه میدهد. در مقابل، اگر دنبال ساخت ویدیوی سریع و بدون دردسر هستید، Pictory برای تولید ویدیو از متن، و Magisto برای ساخت خودکار ویدیو در موبایل، گزینههای بسیار مناسبی هستند.

در کل، اگر تجربه و زمان کافی برای تدوین دارید، سراغ ابزارهای حرفهای بروید؛ اما اگر به دنبال راهی سادهتر و سریعتر هستید، ابزارهای هوش مصنوعی کار را برایتان بسیار آسان کردهاند.

نتیجهگیری

سیستم های هوش مصنوعی وارد دنیای ویرایش ویدیو شده اند و این کار را برای همه از مبتدی تا حرفهای سادهتر کرده است. نرمافزارهایی مانند Premiere Pro و Runway ML برای کاربران حرفهای امکانات پیشرفتهای فراهم میکنند، در حالی که ابزارهایی مثل Magisto، Descript و Pictory راهحلهایی ساده و سریع برای تولید محتوا ارائه میدهند.

انتخاب بهترین نرمافزار ادیت فیلم به کمک هوش مصنوعی به نیاز شما بستگی دارد: اگر دنبال کیفیت و کنترل کامل هستید، گزینههای حرفهای مناسبترند؛ اما اگر سرعت، سادگی و اتوماسیون برایتان مهمتر است، نرمافزارهای هوشمند سبک کارتان را بسیار راحتتر میکنند.

در نهایت، هوش مصنوعی فرصتهای تازهای برای خلاقیت، صرفهجویی در زمان و تولید محتوای جذاب فراهم کرده است. فرصتی که بهتر است از آن استفاده کنیم.