بهترین پردازندههای اینتل برای هوش مصنوعی

هوش مصنوعی به یکی از مهمترین فناوریهای روز دنیا تبدیل شده و در بسیاری از حوزهها مثل پزشکی، خودرو، امنیت، تولید محتوا و خدمات مالی بهکار میرود.

اما برای اجرای مدلهای هوش مصنوعی، به سختافزاری قدرتمند و مناسب نیاز داریم؛ بهویژه پردازندههایی که بتوانند حجم زیادی از دادهها را با سرعت بالا پردازش کنند.

اینتل یکی از قدیمیترین و معتبرترین شرکتهای سازنده پردازنده در دنیاست که علاوه بر پردازندههای عمومی، در سالهای اخیر تمرکز ویژهای بر توسعه سختافزار مخصوص هوش مصنوعی داشته است. این شرکت تلاش کرده با بهروزرسانی پردازندههای کلاسیک خود، و همچنین طراحی تراشههای ویژه، به نیازهای جدید دنیای سیستم های AI پاسخ دهد.

در این مقاله با مهمترین ویژگیهایی که یک پردازنده مناسب هوش مصنوعی باید داشته باشد آشنا میشویم، سپس بهترین پردازندههای اینتل برای اجرای پروژههای AI را معرفی و بررسی خواهیم کرد.

ویژگیهای کلیدی پردازنده مناسب برای هوش مصنوعی

پردازندهای مناسب باید توانایی انجام محاسبات سنگین و همزمان را داشته باشد. چنین پردازندهای معمولاً چند ویژگی کلیدی دارد:

اول، تعداد هستههای بالا بسیار مهم است. در مدلهای یادگیری ماشین، حجم پردازش بسیار زیاد است و وجود هستههای متعدد به اجرای همزمان چند وظیفه کمک میکند.

دوم، پشتیبانی از شتابدهندههای مخصوص AI مثل Intel DL Boost یا AMX باعث میشود پردازنده بتواند برخی محاسبات ماتریسی و عددی را سریعتر از حالت معمول انجام دهد. این ویژگی بهویژه در زمان اجرای مدل (inference) کارایی پردازنده را بهشکل چشمگیری بالا میبرد.

سوم، سرعت و پهنای باند حافظه نیز اهمیت زیادی دارد. چون پردازشهای AI معمولاً به دادههای حجیم نیاز دارند، پردازنده باید بتواند با سرعت بالا به حافظه رم دسترسی داشته باشد تا در اجرای الگوریتمها دچار تأخیر نشود.

در مجموع، پردازندهی مناسب برای هوش مصنوعی فقط قوی بودن کافی نیست؛ بلکه باید معماری آن برای این نوع کار طراحی شده باشد.

بهترین پردازندههای اینتل برای هوش مصنوعی

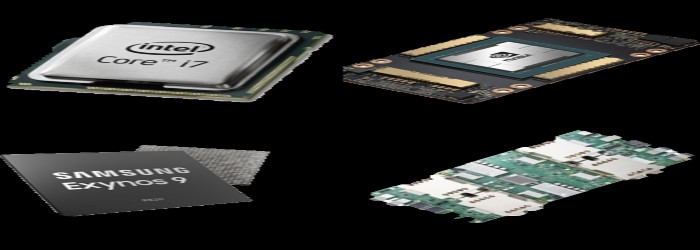

اینتل برای کاربردهای مختلف هوش مصنوعی، پردازندههایی با معماری و توانهای متفاوت عرضه کرده است. در مطالب قبلی به معرفی 10 پردازنده برتر برای هوش مصنوعی پرداختیم در ادامه، بهترین گزینههای برند اینتل را بر اساس نوع کاربرد بررسی میکنیم:

-

بهترین گزینه برای مراکز داده و سرور:

Intel Xeon Scalable (نسل Sapphire Rapids)

این پردازندهها مخصوص پردازشهای سنگین طراحی شدهاند و از فناوریهای پیشرفتهای مثل Intel AMX برای شتابدهی به یادگیری ماشین پشتیبانی میکنند. عملکرد بالا، پشتیبانی از حافظه گسترده و قابلیت مقیاسپذیری آنها را به انتخابی مناسب برای آموزش مدلهای AI در سطح سازمانی تبدیل کرده است.

-

بهترین گزینه برای لپتاپها و رایانههای شخصی Intel Core i7 و i9 (نسل ۱۳ و ۱۴):

پردازندههای نسل جدید Core با پشتیبانی از Intel Deep Learning Boost برای اجرای سریعتر الگوریتمهای AI در دستگاههای مصرفی طراحی شدهاند. این ویژگیها در کاربردهایی مانند پردازش تصویر، تشخیص صدا یا بهینهسازی سیستم، بسیار مفید هستند. اخرین سری پردازنده های اینتل CORE ULTRA نیز به واحد پردازش هوش مصنوعی مجزا مجهز شده اند.

-

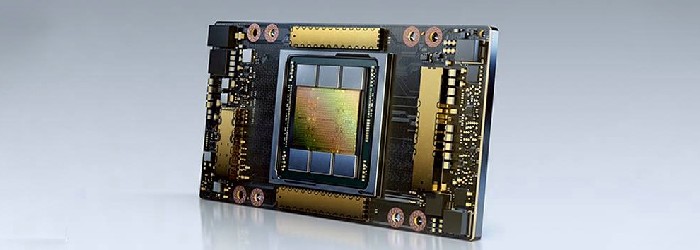

بهترین گزینه برای آموزش مدلهای بزرگ Habana Gaudi 2:

این پردازنده که توسط شرکت زیرمجموعه اینتل طراحی شده، برای آموزش مدلهای یادگیری عمیق در مقیاس بزرگ ساخته شده است. Gaudi 2 از نظر کارایی و مصرف انرژی، رقیبی جدی برای GPUهای حرفهای است و در برخی پروژههای AI سطح بالا جایگزین GPUهای انویدیا شده.

- بهترین گزینه برای پردازش هوش مصنوعی در لبه شبکه (Edge) اینتل سری Atom:

برای دستگاههایی که در لبه شبکه کار میکنند مثل دوربینهای هوشمند، رباتها یا تجهیزات صنعتی—پردازندههای کممصرف اینتل با پشتیبانی از شتابدهندههای سبک AI، گزینهای عالی هستند. آنها میتوانند مدلهای کوچک را بدون نیاز به اتصال دائمی به سرور اجرا کنند.

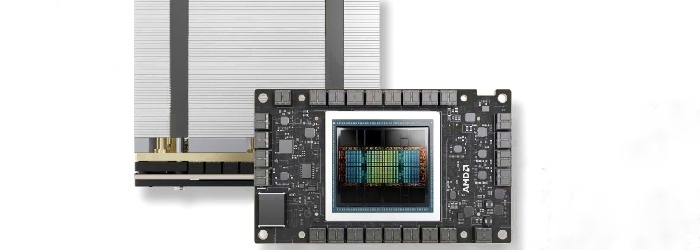

مقایسه کوتاه با AMD در حوزه هوش مصنوعی

در رقابت بین اینتل و AMD، هر دو شرکت تلاش کردهاند پردازندههایی بسازند که بتوانند نیازهای پردازشی سنگین، از جمله هوش مصنوعی را پاسخ دهند. اما رویکرد این دو برند در طراحی سختافزار برای AI تفاوتهایی دارد.

AMD با پردازندههای سری EPYC در سرورها و Ryzen در کامپیوترهای شخصی، عملکرد چشمگیری در پردازشهای چندهستهای و مصرف انرژی ارائه داده است. اما در زمینه ویژگیهای اختصاصی برای هوش مصنوعی، اینتل معمولاً جلوتر است. پردازندههای اینتل از قابلیتهایی مثل DL Boost و AMX بهره میبرند که بهطور خاص برای اجرای الگوریتمهای AI طراحی شدهاند.

در مقابل، AMD بیشتر بر قدرت خام پردازشی و تعداد هستهها تمرکز دارد، و هنوز در زمینهی شتابدهندههای داخلی برای هوش مصنوعی، گستردگی و بلوغ فناوریهای اینتل را ندارد. البته AMD نیز با استفاده از کارتهای گرافیک سری Instinct وارد رقابت در پردازشهای AI شده، اما تمرکز اصلی آن در GPUهاست، نه CPU.

در مجموع، اگر هدف استفاده از پردازنده مرکزی (CPU) برای هوش مصنوعی باشد، اینتل در حال حاضر مزایای بیشتری ارائه میدهد—مخصوصاً در محیطهای سازمانی و کاربردهای حرفهای.

آینده پردازندههای اینتل در حوزه هوش مصنوعی

اینتل با سرعت زیادی در حال توسعه پردازندههایی برای کاربردهای متنوع هوش مصنوعی است. نسلهای جدید پردازندههای Xeon با شتابدهندههایی مثل AMX طراحی شدهاند تا اجرای مدلهای یادگیری ماشین سریعتر و بهینهتر شود.

همزمان، اینتل با پردازندههای Habana Gaudi به حوزه آموزش مدلهای بزرگ AI نیز وارد شده. این شرکت تلاش دارد با کاهش مصرف انرژی و افزایش سرعت، جایگزینی برای GPUهای سنگین ارائه دهد.

در بخش هوش مصنوعی لبهای (Edge AI) نیز اینتل سرمایهگذاری زیادی کرده تا پردازندههایی تولید کند که بتوانند مدلهای سبک را بدون اتصال به سرور، روی دستگاههای کوچک اجرا کنند.

جمعبندی و نتیجهگیری

پردازندههای اینتل در سالهای اخیر به یکی از گزینههای اصلی برای اجرای پروژههای هوش مصنوعی تبدیل شدهاند. با تنوع در محصولات، این شرکت توانسته نیازهای مختلف را از لپتاپهای سبک تا دیتاسنترهای پیشرفته پوشش دهد.

در مقایسه با رقیب اصلی یعنی AMD، اینتل همچنان در زمینهی شتابدهندههای داخلی و پشتیبانی سختافزاری برای AI، مزیتهایی دارد، مخصوصاً در سطح سازمانی و صنعتی.

در نهایت، انتخاب بهترین پردازنده به نوع پروژه و محیط اجرا بستگی دارد، اما اینتل با تمرکز بر نوآوری و توسعهی تخصصی در حوزه هوش مصنوعی، یکی از مطمئنترین انتخابها باقی مانده است.